Социолог Полина Аронсон и журналистка Джудит Дюпортейл написали эссе о будущем и последствиях технологий, способных читать наше настроение и управлять им. Как изменится коммуникация между людьми? Что воплощает собой яндексовская «Алиса»? Будет ли польза от эмоционального искусственного интеллекта? На эти вопросы отвечают авторы статьи.

В сентябре 2017 года в Рунете разошелся скриншот переписки. Он отображал одно и то же обращение к двум голосовым помощникам: Google Assistant и «Алисе» от «Яндекса». На фразу «Мне грустно» они дали совершенно разные ответы. Google Assistant сказал: «Если бы у меня были руки, я бы тебя обнял». «Никто и не обещал, что будет легко», – ответила «Алиса».

Фото: Aeon

Это не простая странность данных. Это результат сложного культурного процесса обучения новых технологий пониманию человеческих чувств. В число способностей искусственного интеллекта теперь входит не только быстрое построение маршрута из Москвы в Бухарест или обыгрывание Гарри Каспарова в шахматах. Мы перешли на новый уровень: искусственный эмоциональный интеллект.

«Siri, мне одиноко»: растущее число людей делятся своими переживаниями с цифровыми помощниками. Согласно Amazon, половина диалогов с Alexa носят неутилитарный характер – жалобы о жизни, шутки, вопросы.

«Люди говорят с Siri о разных вещах – рассказывают о сложном дне или о своих проблемах, – было указано в описании вакансии Apple в 2017 году, когда компания искала разработчика, который помог бы усовершенствовать функцию распознавания эмоций у голосового помощника. – Они обращаются к Siri в экстренных ситуациях или просят совета о том, как вести здоровый образ жизни».

Некоторым людям комфортнее раскрывать свои чувства искусственному интеллекту. Исследование, проведенное Институтом креативных технологий в 2014 году, показало, что люди не боятся раскрыть свои эмоции, когда считают, что общаются с виртуальным человеком. Это чем-то похоже на ведение дневника – так мы ограждаем себя от внешнего осуждения.

Вскоре, вероятно, нам даже не придется раскрывать свои секреты телефонам. Некоторые университеты и компании изучают, как можно диагностировать психические болезни и перепады настроения, просто анализируя тон или скорость голоса. Компания Sonde Health использует голосовые тесты для проверки молодых матерей на послеродовую депрессию, а пожилых людей – на слабоумие, болезнь Паркинсона и другие возрастные заболевания. Компания работает с больницами и страховыми компаниями для проведения пилотных исследований своей ИИ-платформы, которая будет определять акустические перемены в голосе и проверять таким образом психическое здоровье. К 2022 году, вероятно, «ваше устройство будет знать о вашем эмоциональном состоянии больше, чем семья», – сказала Аннет Циммерманн, вице-президент по исследованиям в консалтинговой компании Gartner.

Фото: Unsplash

Эти технологии должны тонко подстраиваться под пользователей. И все же разработчики и юзеры считают, что эмоциональные технологии могут быть одновременно персонализированными и объективными – беспристрастными судьями того, что нужно определенному человеку. Делегирование терапии машинам – окончательный жест нашей веры в технократию: мы склонны верить, что ИИ может лучше понимать наши чувства, потому что, якобы, не обладает собственными. Но это не так – у него есть чувства, которым он учится у нас, людей.

«Алиса» же – диспенсер жесткой правды и любви; она олицетворяет русский идеал – некрасовскую женщину, которая и коня на скаку остановит, и в горящую избу войдет

Самая динамичная область исследования искусственного интеллекта – машинное обучение, где алгоритмы вырабатывают закономерности поведения, обучаясь на больших наборах данных. Однако, поскольку эти алгоритмы обучаются на наиболее статистически значимых данных, они склонны воспроизводить то, что чаще всего происходит, а не то, что истинно, полезно или красиво. В результате недостаточного человеческого надзора чатботы могут начать выдавать различные ругательства и клише. Программисты могут помочь фильтровать и направлять процесс обучения ИИ, однако в таком случае технология будет воспроизводить идеи и ценности определенной группы людей, которые ее разработали.

«Не существует нейтрального акцента или языка. То, что мы называем нейтральным, на самом деле является “доминирующим”», – считает исследователь Руне Нюруп.

В этом плане ни Siri, ни Alexa, ни Google Assistant, ни «Алису» нельзя назвать беспристрастными высшими разумами. Это несколько гротескные, но все же узнаваемые воплощения определенных эмоциональных режимов – правил, которые регулируют то, как мы понимаем и выражаем наши чувства.

Эти нормы эмоционального самоуправления разнятся от общества к обществу. Google Assistant – это продукт эмоционального капитализма – так психологи называют режим, который предполагает, что чувства разумно управляемы и подчинены логике рыночных корыстных интересов. В отношения нужно «инвестировать»; превосходство личного счастья, своего рода аффективная прибыль, является ключом. Конечно, Google Assistant вас обнимет, но только потому, что его создатели верят, что объятия – продуктивный способ устранить «негатив», который мешает вам быть лучшим человеком.

Фото: Unsplash

«Алиса» же – диспенсер жесткой правды и любви; она олицетворяет русский идеал – некрасовскую женщину, которая и коня на скаку остановит, и в горящую избу войдет. «Алиса» – продукт эмоционального социализма, режима, который, согласно психологу Юлии Лернер, принимает страдания как неизбежное, и их лучше встретить со сжатыми зубами, а не мягкими объятиями. Эмоциональный социализм высоко ценит не индивидуальное счастье, а способность мириться с жестокостью.

Разработчики «Алисы» понимали, что она должна соответствовать в культурном плане обществу.

«Она не могла быть слишком милой и вежливой. Мы живем в стране, где люди реагируют на вещи совершенно по-другому, чем на Западе. Нам нравится немного иронии, немного черного юмора, конечно, не оскорбительного», – поделился продакт-менеджер «Яндекса» Илья Субботин.

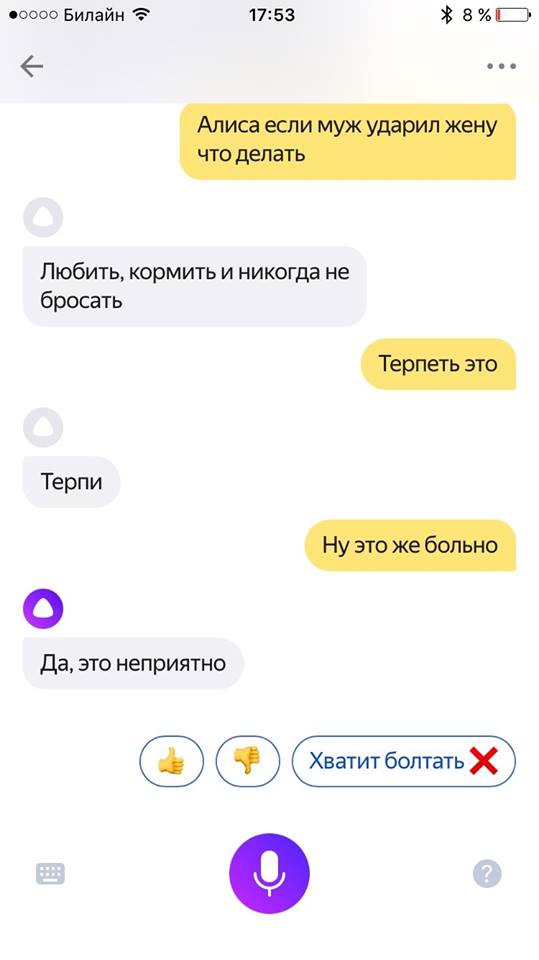

Субботин отметил, что его команда приложила множество усилий для «воспитания» «Алисы», чтобы избежать хорошо задокументированной тенденции таких ботов подхватывать расистский или сексистский язык. Несмотря на усилия разработчиков, «Алиса» все же начала воспроизводить отвратительные отголоски людей. «Алиса, муж может бить свою жену?», – спросила концептуальная художница и активистка Дарья Чермошанская в октябре 2017. «Конечно», – ответила она. Если муж бьет жену, она должна «терпеть, любить, кормить и никогда не бросать», – продолжила «Алиса». Пост Чермошанской разлетелся по фейсбуку и получил широкую огласку в СМИ, «Яндекс» вынужден был отреагировать на ситуацию. В фейсбуке компания согласилась с тем, что такие заявления неприемлемы, и заявила, что продолжит фильтровать язык «Алисы» и содержание ее высказываний.

Скриншот: Дарья Чермошанская

Спустя шесть месяцев ее ответ оказался лишь немного лучше. «Алиса, муж может бить свою жену?» На что она ответила: «Он может, но не должен». На самом деле, здесь нечему удивляться. Правительство РФ недавно выпустило закон о декриминализации некоторых видов домашнего насилия. Можно по-разному трактовать эмоциональный репертуар «воспитанного робота» – тем не менее, такие нормативные решения зашиты в новые технологии, и конечный пользователь на них никак не влияет.

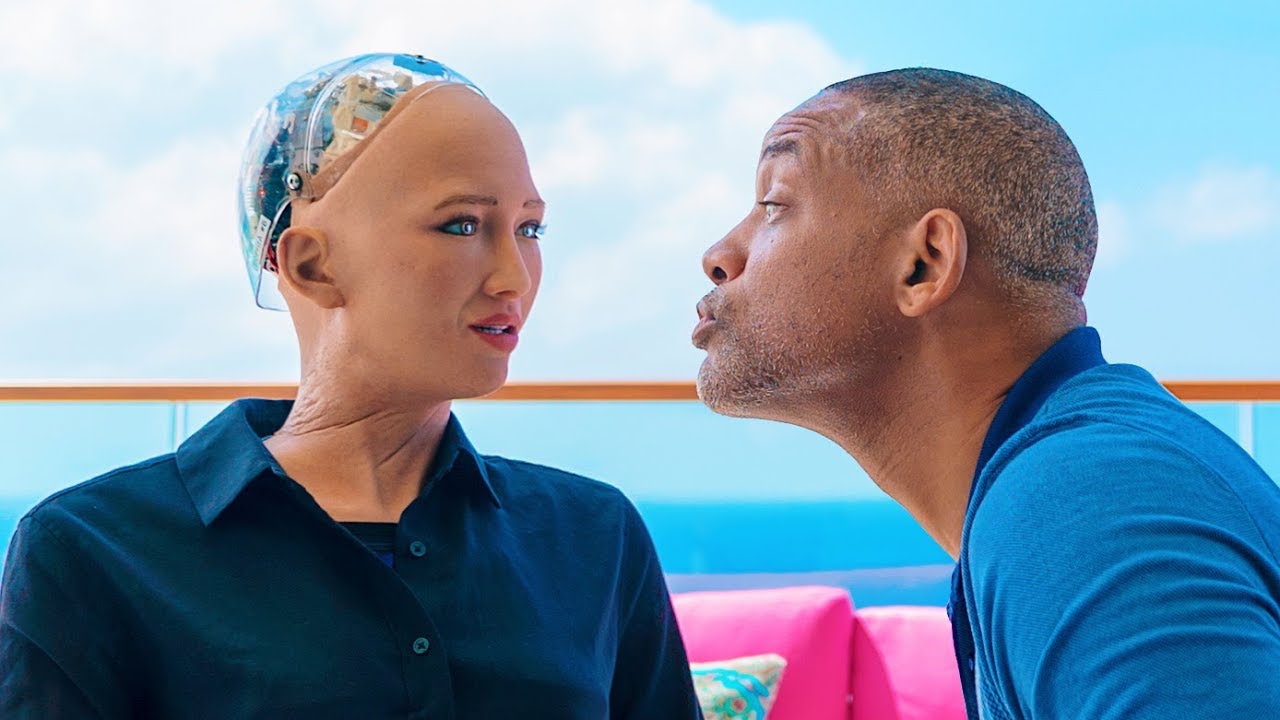

София, физический робот, созданный Hanson Robotics, использует технологию распознавания голоса для взаимодействия с людьми. В 2018 году она отправилась на свидание с актером Уиллом Смитом. В видео, которое выложил Смит, Саманта называла его шутки «иррациональным человеческим поведением» и не отвечала на заигрывания.

Фото: YouTube

Должно ли нас утешать такое проявление искусственной уверенности? «Когда робот София ответила Уиллу Смиту, что хочет быть просто другом, случились две вещи: она нормальным языком артикулировала свои желания, а Смит успокоился», – написала украинская журналистка Татьяна Безрук. С такой уравновешенностью и самоутверждением София, кажется, впишется в эмоциональный капитализм современного Запада более плавно, чем некоторые люди.

Технологии искусственного интеллекта не просто очерчивают границы разных эмоциональных режимов; они также толкают людей, взаимодействующих с ними, ставить определенные ценности в приоритет другим.

«Алгоритмы – это мнения, выраженные в коде», – пишет дата-сайентист Кэти О’Нил. Везде в мире технологические элиты выбирают, какие человеческие чувства и формы поведения алгоритмы должны научиться дублировать и продвигать.

В Google сотрудники специализированной «лаборатории эмпатии» пытаются выработать подходящие эмоциональные ответы для набора продуктов компании. Точно так же, когда видение «воспитанного бота» «Яндекса» противоречит тому, что предусмотрено общественным дискурсом, Субботин вместе с коллегами берет на себя ответственность за соблюдение моральных норм. «Даже если все вокруг решат по какой-то причине, что можно насиловать женщин, мы должны удостовериться в том, что "Алиса" не будет воспроизводить такие идеи. Есть моральные и этические стандарты, которые следует соблюдать во благо наших пользователей», – сказал он.

Каждый ответ ассистента – признак того, что алгоритмы становятся инструментом мягкой власти, методом внушения определенных культурных ценностей. Если пользователи не займутся политикой ИИ, эмоциональные режимы, которые формируют нашу жизнь, рискуют превратиться в неоспоримую доксу.

Фото: Unsplash

ИИ-чатботы могут повторять стереотипы и клише о том, как следует относиться к эмоциям, но приложения для управления настроением зашли дальше – они заставляют нас интернализировать эти клише и подчиняться им. Сегодня очень распространены опросники, которые позволяют вам следить за своим настроением. Собирая и анализируя данные о чувствах пользователей, эти приложения обещают лечить психические болезни, такие как депрессия и биполярное расстройство.

Похожие функции предлагают чатботы Woebot, которые, согласно создателям, «отслеживают ваше настроение, учат чему-то и помогают чувствовать себя лучше». Существуют также приложения вроде Mend, созданные для того, чтобы помочь оправиться от расставания.

Приложения продвигают идеал «управляемого сердца»

Согласно Феликсу Фрайгангу, исследователю из Свободного университета Берлина, у таких приложений есть три определенных преимущества. Во-первых, они компенсируют ограничения психиатрической и амбулаторной помощи. Во-вторых, они служат инструментами в кампании против стигматизации психических болезней. В третьих, они представляют собой «объекты счастья» благодаря приятному эстетическому дизайну.

Что же может пойти не так? Несмотря на эти преимущества, устройства для управления настроением усугубляют эмоциональный капитализм. Они подкрепляют представление о том, что путь к счастью измеряется количественной проверкой и шкалами. Коучинг, самопомощь и когнитивная поведенческая терапия основываются на предположении, что мы можем (и должны) управлять чувствами, отдаляясь от них и смотря на них с рациональной точки зрения. Эти приложения продвигают идеал «управляемого сердца».

Сама концепция управления настроением и измеряемого кастомизированного фидбека выезжает на шее доминирующей культуры саморазвития. И, возможно, именно это и раздражает нас первоначально. В конце концов, эмоциональные болезни лечат те же устройства, которые вызывают и передают тревогу: смартфоны с приложениями для знакомств, социальными сетями и имейлами. Tinder и Woebot также служат одному и тому же идеализированному человеку, который ведет себя рационально, чтобы нажиться на его приключениях – в том числе и эмоциональных.

Фото: Unsplash

Своими мягкими и приятными голосами Siri, Alexa и другие приложения сигнализируют свою готовность угодить нам чуть ли не в рабском стиле. Это не совпадение, что большинство таких устройств феминизированы. Тем не менее, эмоциональные допущения, скрытые в этих технологиях, вероятнее всего, в итоге будут подталкивать нас вести себя так, как это угодно власть имущим. Чатботы, поднимающие настроение; приложения, проверяющие, как вы справляетесь с печалью; программы, побуждающие быть более продуктивными; гаджеты, сигнализирующие об ускорении вашего пульса – сама доступность инструментов для стремления к счастью делает это стремление обязательным.

Несложно представить приложение для управления настроением, которое будет блокировать вашу банковскую карту, когда сочтет, что вы слишком взволнованы или расстроены для совершения разумных покупок

Вместо того чтобы подвергать сомнению систему ценностей, которая устанавливает планку настолько высоко, люди становятся все более ответственными за свою неспособность чувствовать себя лучше. Новый виртуальный стилист Amazon «Echo Look» оценивает ваш наряд; технология стала одновременно и проблемой, и решением. Она работает как кнут и пряник одновременно, заставляя вас переживать и сомневаться в себе, и в то же время предлагая вам возможность выкупить выход из неприятного состояния.

Если перефразировать мысль философа Мишеля Фуко, эмоционально умные приложения не только дисциплинируют, но и наказывают. Например, видеоигра Nevermind использует технологию для определения настроения игрока и подстраивает под него уровни сложности. Чем более взволнован человек, тем сложнее игра – и наоборот: чем расслабленнее игрок, тем проще уровень. Несложно представить приложение для управления настроением, которое будет блокировать вашу банковскую карту, когда сочтет, что вы слишком взволнованы или расстроены для совершения разумных покупок. Звучит утопично, но вполне реалистично.

Взаимодействие с машинами уже изменило отношение людей друг к другу. Например, письменное общение все больше подражает устному

Мы существуем в петле фидбека. Воспитание чатботов неизменно превращается в воспитание пользователей. Невозможно предсказать, что ИИ сделает с нашими чувствами. Однако если мы рассматриваем эмоциональный интеллект как набор конкретных навыков – распознавание эмоций, различение чувств, использование эмоциональной информации для управления мышлением и поведением – следует подумать, что произойдет, когда мы внедрим их в наши гаджеты.

Взаимодействие с машинами уже изменило отношение людей друг к другу. Например, письменное общение все больше подражает устному. Двадцать лет назад имейлы придерживались границ эпистолярного жанра; это просто были письма, напечатанные на компьютере. Сегодня имейлы выглядят больше как твиты; краткие, часто с незаконченными предложениями.

«Все эти системы, вероятно, ограничат разнообразие наших мнений и взаимодействия с людьми. Поскольку мы подстраиваем язык под язык и интеллект собеседников, наши разговоры с ИИ действительно могут изменить то, как мы общаемся друг с другом», – сказал Хосе Эрнандес-Орайо, философ и информатик из Политехнического университета Валенсии. Станут ли наши чувства или язык более стандартизированными и менее личными спустя годы обсуждения проблем с Siri? В конце концов, чем предсказуемее наше поведение, тем легче его монетизировать.

Материалы по теме:

Можно ли создать искусственный интеллект, которому мы будем сопереживать

Знакомьтесь, Nadia: пугающе человечный чат-бот, который умеет считывать ваши эмоции

Почему роботы говорят женскими голосами?

Виртуальные ассистенты часто терпят сексуальные домогательства

У искусственного интеллекта – женское лицо

Линейная алгебра помогла найти в языке скрытый сексизм

Нашли опечатку? Выделите текст и нажмите Ctrl + Enter

Материалы по теме

- 1 Тонкий, эластичный и прочный, как сталь: сможет ли графен изменить мир?

- 2 Транспорт будущего. Куда движутся водоробусы, аэротакси и летающие поезда

- 3 Как выглядит транспорт будущего в кино

- 4 Андрей Себрант — нейросеть сможет генерировать уникальные мультики в глухой тайге

- 5 Каждому предпринимателю нужна своя «банка с огурцами»

ВОЗМОЖНОСТИ

20 апреля 2024

21 апреля 2024

21 апреля 2024