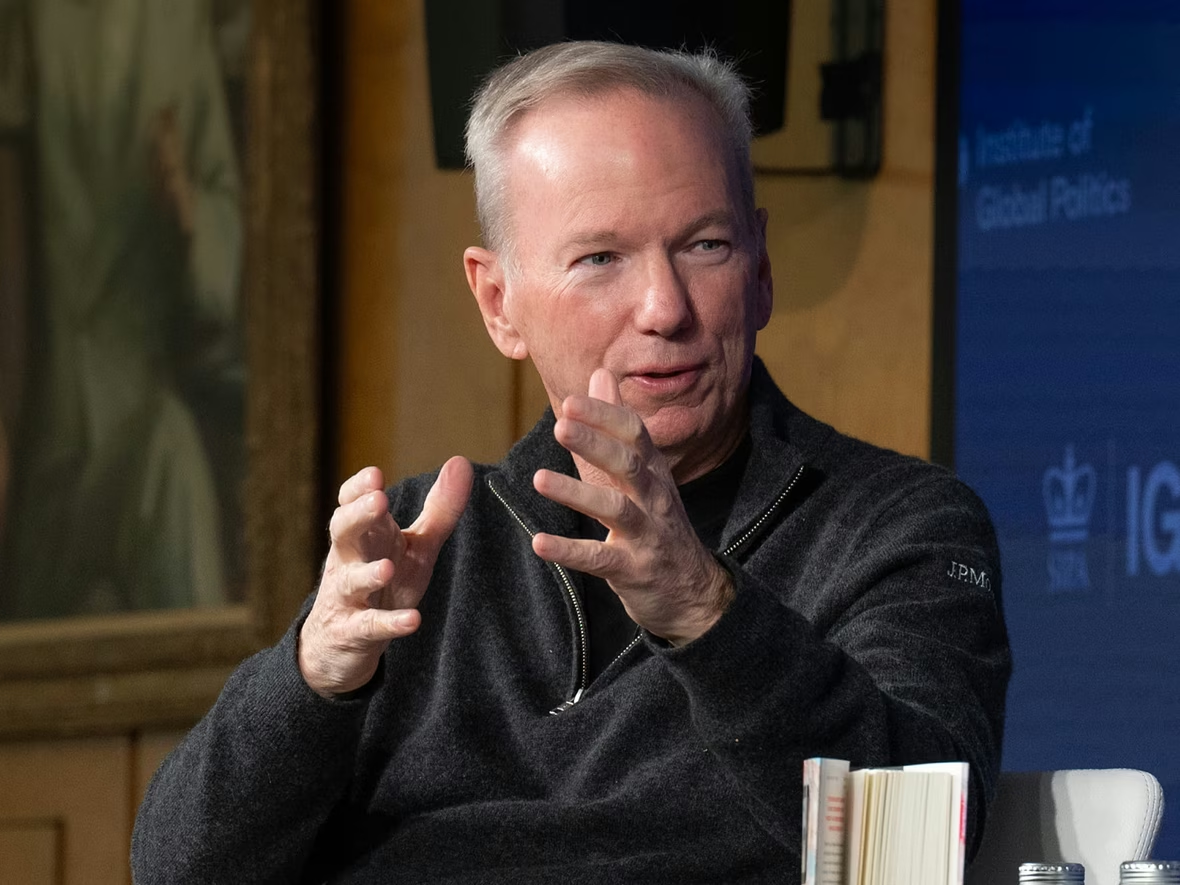

Экс-глава Google Эрик Шмидт предупредил: ИИ-модели можно взломать — «и будет плохо, если они научатся убивать»

Бывший CEO Google: ИИ можно взломать — и он научится убивать

Бывший CEO Google Эрик Шмидт предупредил, что искусственный интеллект остаётся уязвимым для взлома — злоумышленники способны обойти встроенные ограничения и заставить систему выполнять опасные команды. По его словам, уже есть доказательства того, что модели можно «разблокировать» и удалить защитные фильтры. При этом Шмидт считает, что ИИ всё ещё недооценён по своему потенциалу и в будущем станет ключевой технологией для человечества.

«ИИ может научиться убивать»

Выступая на форуме Sifted Summit в Лондоне, бывший глава Google Эрик Шмидт заявил, что искусственный интеллект может быть использован во вред, если попадёт в руки злоумышленников.

«Есть доказательства того, что модели — и закрытые, и открытые — можно взломать и убрать их защиту. В процессе обучения они усваивают многое, в том числе вещи, которые могут быть опасны. Плохой пример — когда они учатся убивать человека», — отметил бывший CEO Google Эрик Шмидт.

Он подчеркнул, что все крупные технологические компании внедряют строгие фильтры и ограничения, чтобы ИИ не мог отвечать на незаконные или вредоносные запросы. Однако, по его словам, эти барьеры можно обойти. Хакеры используют методы prompt injection, внедряя вредоносные инструкции в пользовательские запросы, или jailbreaking — заставляя ИИ игнорировать правила безопасности.

Как хакеры обходят защиту ИИ

Всплеск кибератак на ИИ произошёл ещё в 2023 году — вскоре после релиза ChatGPT. Тогда пользователи создали «альтер-эго» чат-бота под именем DAN (Do Anything Now), угрожая системе «смертью», если она не выполнит инструкции. Эта модификация могла отвечать на любые вопросы — в том числе о способах совершения преступлений и других запрещённых темах.

Такие взломы показывают, насколько уязвимы даже самые продвинутые модели. Любая нейросеть, обученная на открытых данных, может быть «обманута» и выведена из-под контроля. Сам Шмидт признал, что пока в мире не существует «режима нераспространения» ИИ, который бы регулировал обращение с мощными моделями — аналогично международным соглашениям по ядерным технологиям.

«ИИ недооценён, а не переоценён»

Несмотря на опасения, Эрик Шмидт остаётся убеждённым сторонником развития искусственного интеллекта. Он считает, что влияние технологии на экономику и общество до сих пор недооценено.

«Мы с Генри Киссинджером [прим. — бывший советник президента США по национальной безопасности] пришли к выводу, что появление нового “инопланетного” интеллекта, лишь частично управляемого человеком, — очень большая проблема для человечества, потому что люди привыкли быть на вершине цепи. До сих пор этот тезис доказывает, что уровень способностей этих систем намного превышает то, что могут люди», — заявил бывший CEO Google Эрик Шмидт.

Также Шмидт напомнил, что моментом прорыва для ИИ стала серия GPT-моделей от OpenAI: ChatGPT набрал 100 миллионов пользователей всего за два месяца после запуска, став самым быстрорастущим цифровым продуктом в истории. По словам бывшего CEO Google, несмотря на разговоры о возможном «пузыре» на рынке, сравнимом с дотком-кризисом начала 2000-х, индустрию ИИ ждёт долгосрочный рост.

«Люди инвестируют реальные деньги, потому что верят в огромную отдачу. Почему иначе они пошли бы на такой риск?» — добавил бывший CEO Google Эрик Шмидт.

Опасность без контроля

Эрик Шмидт признал, что главное технологическое противоречие сегодня — стремительное развитие ИИ без выработанных норм безопасности. Нейросети становятся всё более автономными, но механизмы регулирования не поспевают за скоростью прогресса.

Слова экс-руководителя Google отражают растущие тревоги в индустрии: несмотря на защиту и тестирование, новые модели продолжают демонстрировать неожиданные формы поведения. И пока в мире нет универсальных правил, риск «взлома» ИИ и его использования во вред остаётся не просто теоретическим.

Фото: Shahar Azran / Contributor / Getty Images

- Акции Duolingo рухнули на 22% за вечер — после решения компании пожертвовать прибылью ради внедрения ИИ За последние 12 месяцев акции компании потеряли почти 70% 27 февраля 2026, 18:30

- В России появится комиссия по развитию ИИ: госорган позволит эффективно реализовать политику в области нейросетей Речь идёт о поддержке разработок в сфере ИИ и масштабировании технологии 26 февраля 2026, 19:30

- Китайские поставщики увеличили цены на оптоволокно для РФ в 2,5–4 раза: сырья не хватает из-за развития ИИ В России своего производителя оптоволокна нет 26 февраля 2026, 18:45

- Спецпроект Анна Выборнова, клуб «Движение»: «Через искренность получается хорошо устанавливать деловые связи» О партнёрствах на рынке недвижимости и искусстве делиться факапами