Стивен Хокинг: создание ИИ станет «либо лучшим, либо худшим» событием в истории человечества

В Кембриджском университете создан институт для изучения будущего искусственного интеллекта. По этому поводу известный физик-теоретик Стивен Хокинг рассказал, какое будущее ожидает человечество в эру ИИ.

Профессор Стивен Хокинг предупредил, что создание мощного искусственного интеллекта «станет либо лучшим, либо худшим событием в истории человечества», и поприветствовал создание научной организации, которая будет заниматься исследованием перспектив искусственного интеллекта как «критически важного вопроса для будущего нашей цивилизации и нашего вида».

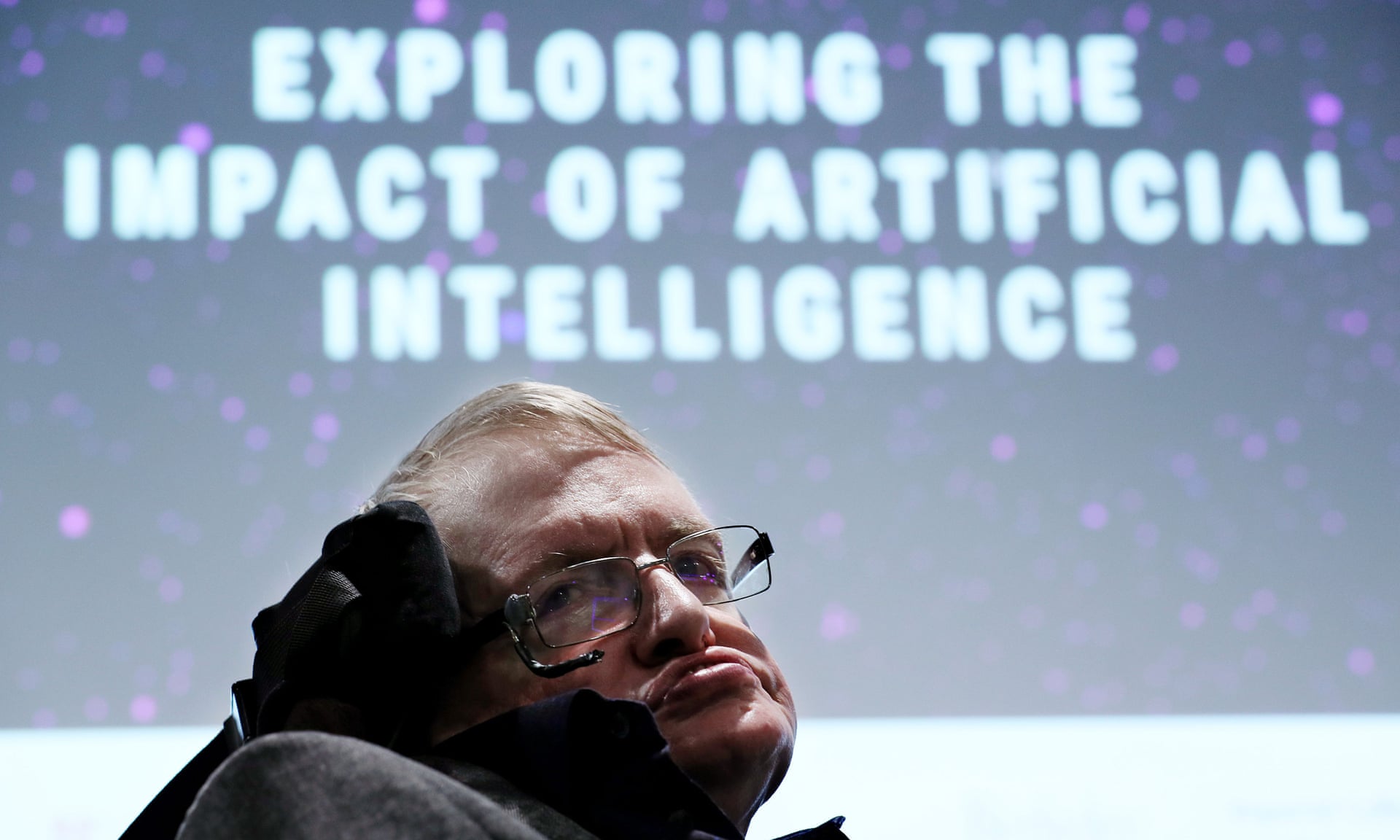

Стивен Хокинг на открытии Центра будущего интеллекта имени Леверхалма в среду. Фото: Крис Радберн/PA

Хокинг выступал в Кембриджском университете на церемонии открытия Центра будущего интеллекта имени Леверхалма (LCFI) – междисциплинарного института, сотрудники которого попытаются найти ответы на некоторые из открытых вопросов, поднятых в ходе стремительного развития технологий ИИ.

«Мы посвящаем очень много времени изучению истории, – сказал Хокинг. – Которая, давайте взглянем правде в глаза, по большей части является историей глупости. Так что людям пойдет на пользу вместо этого изучать будущее интеллекта».

Хотя знаменитый физик всегда настороженно относился к ИИ и заявлял, что человечество рискует и может стать архитектором собственного конца, если создаст сверхинтеллект с независимой волей, он также быстро нашел положительные стороны изучения ИИ.

«Сложно переоценить потенциальные преимущества создания интеллекта, – сказал он. – Мы не может предугадать, чего сможем достичь, если наш разум будет усилен ИИ. Возможно, плоды этой новой технологической революции помогут нам возместить ущерб, нанесенный природе в ходе предыдущей революции – индустриализации. Кроме того, можно будет по-новому взглянуть на решение проблем болезней и бедности».

Хув Прайс – академический директор Центра. Фото: Джон Тонкс

«Наша жизнь изменится во всех аспектах. Говоря короче, успех в создании ИИ может стать важнейшим событием в истории нашей цивилизации».

Хув Прайс, академический директор Центра и профессор философии Кембриджского университета, где Хокинг тоже носит звание академика, заявил, что его организация появилась отчасти благодаря работе Центра экзистенциальных рисков. Этот институт, который таблоиды окрестили «местом изучения Терминаторов», занимается более широким диапазоном проблем, в то время как сфера интересов LCFI имеет достаточно узкую сферу интересов.

«Мы пытаемся избавиться от этих ассоциаций с "терминаторами", – говорит Прайс. – Но, как и их прототип, они возвращаются снова и снова».

Пионер ИИ, профессор когнитивных наук в Университете Сассекса Маргарет Боден тоже одобряет развитие подобных дискуссий. Еще в 2009 году она отмечала, что эту тему не воспринимают всерьез даже сами исследователи ИИ. «Сфера искусственного интеллекта крайне увлекательна, – считает она – но у нее есть ограничения, которые могут превратиться в смертельные угрозы, если мы не подойдем к делу критически».

О потенциальных опасностях ИИ наравне с его преимуществами говорят не только в научном сообществе. Свои опасения по поводу вреда, который искусственный сверхинтеллект может нанести человечеству, выражали и многие лидеры технологической отрасли, в том числе предприниматель Илон Маск.

Материалы по теме:

Что произойдет с чат-ботами и искусственным интеллектом в ближайшие два года?

Искусственный интеллект охраняет тебя. Почему вы всегда в безопасности, заказывая Uber

Специалист по нейронаукам рассказывает о будущем со сверхчеловеческим интеллектом

Финансируемый Илоном Маском стартап создает «полицию искусственного интеллекта»

Нашли опечатку? Выделите текст и нажмите Ctrl + Enter

Популярное

Налог на прибыль организаций

Материалы по теме

-

Пройти курс «Старт работы на Ozon»

- 1 Стартап Ильи Суцкевера привлек $2 млрд на создание «безопасного сверхразума» Компания получила оценку в $32 млрд 13 апреля 14:26

- 2 OpenAI подала встречный иск против Илона Маска, обвинив его в преследовании Компания попросила суд привлечь предпринимателя к ответственности 10 апреля 14:41

- 3 Популярность ChatGPT побила рекорды благодаря фильтру в стиле Хаяо Миядзаки Среднее количество еженедельных активных пользователей превысило 150 млн 01 апреля 19:19

- 4 OpenAI открыла доступ к новому генератору изображений для всех пользователей Ранее им могли воспользоваться лишь обладатели платной подписки 01 апреля 18:51