Как технологии распознают наши эмоции и почему это так перспективно

Георгий Плиев, управляющий партнер Neurodata Lab, рассказывает о состоянии и перспективах нового технологического рынка – рынка детекции эмоций.

Как технологии научились распознавать эмоции

Интерес к сфере распознавания эмоций зародился в начале нулевых и достиг своего пика в 2016 году. На рубеже 2015-2016 годов многие российские и зарубежные стартапы стали использовать нейросети для создания развлекательных приложений. Например, можно загрузить фото, и приложение, анализируя мимику, покажет результат, где в процентах указано насколько человек испытывает ту или иную эмоцию.

У таких приложений есть одна проблема – все они распознают эмоции только по мимике на лице, не учитывая иные эмоциональные проявления – положение тела в пространстве, жесты, взгляд, сердцебиение и так далее. Для распознавания истинных эмоций требуется больше каналов, соответственно, нужны и другие, более сложные технологии.

Сейчас рынок детекции эмоций переживает бум и по оценке западных специалистов к 2021 году он вырастет, по разным подсчетам, от $19 млрд до $37 млрд. Давайте подробнее рассмотрим что такое эмоции, каков объем рынка и его прогнозируемый рост и какие компании уже занимают нишу детекции эмоций.

Рынок детекции эмоций

Сегодня, в 2017 году, трудно отрицать очевидный факт: исследования в области искусственного интеллекта – фундаментальные и сугубо прикладные, развиваемые под эгидой и в интересах государства, а равно финансируемые корпорациями, фондами и частным бизнесом – окончательно обрели самостоятельный рыночный статус, представляя собой привлекательную для масштабных и долгосрочных инвестиционных вложений индустрию.

Речь идет о сложной, включающей много направлений, наукоемкой отрасли, стабильно демонстрирующей впечатляющие темпы роста. Технологии по распознаванию эмоций, физиологических состояний, поведенческих паттернов человека, а также смежные с ними, устоявшиеся содержательно и терминологически «эмоциональные вычисления» (affective computing), – её важнейшая составная часть.

Эмоциональные (или же аффективные) технологии успешно преодолели начальную фазу становления, они перестали быть недосягаемыми и встроились в актуальный рыночный контекст.

Неоспорим исключительно междисциплинарный метод, лежащий в их основе: естественные и когнитивные науки (биология, психофизиология, нейролингвистика) здесь смыкаются и вступают в тесные формы взаимодействия с наукой о данных, компьютерным зрением, глубоким обучением, технологиями по обработке визуальной, акустической и речевой информации.

Поэтому небезынтересно взглянуть на то, чем является и в какую сторону движется рынок систем детекции и распознавания эмоций (EDRS – Emotion Detection&Recognition Systems), не забывая о его молодости (new emerging market), пластичности и технологических горизонтах, к которым еще только предстоит приблизиться на практике.

Оценка объемов рынка

Системы детекции и распознавания эмоций (EDRS) и эмоциональные вычисления (affective computing) формируют собственную экосистему в поле разработок искусственного интеллекта (AI). Оценки объемов этого рынка и его перспектив на период до 2022 года разнятся, поскольку отталкиваются от различных метрик и формул подсчета.

Впрочем, несколько сводных отчетов, выпущенных в конце 2016 – начале 2017 года, иллюстрируют общий тренд: так, по мнению Markets&Markets, текущий показатель глобального рынка эмоциональных технологий – $6,72 млрд в 2016 году – достигнет планки $36,07 млрд к 2021 году, с ежегодным ростом в 39,9%. Reportlinker и Orbis Research придерживаются более консервативных прогнозов – $29,17 млрд/27,4% и $19,96 млрд/21,2% к 2022 году, соответственно.

Разумеется, цифры взмывают вверх, если пытаться охватить взглядом всю отрасль affective computing в широком смысле – $53,98 млрд к 2021 году/34,7% в годовом исчислении, как предполагает Markets&Markets – однако не стоит обольщаться, поскольку здесь учитывается колоссальный вклад локомотивов рынка – корпоративных игроков вроде IBM, Google, Apple, Facebook, Microsoft.

Референтными для индустрии остаются три географические зоны: Азиатско-Тихоокеанский регион (АТР), Северная Америка (США и Канада) и Европейский Союз. Наиболее привлекательные темпы демонстрируют по-прежнему два канала анализа эмоций: распознавание микроэкспрессий лица и биосенсорные датчики, встроенные в носимые устройства. Следом идут голос/речь и видеоокулография (айтрекинг).

Каковы бы ни были расхождения по конкретным цифрам, к ним можно относиться с высокой степенью доверия: имеющиеся аппаратное оборудование и программное обеспечение позволяют с гораздо большей точностью, чем десять лет назад, считывать и кластеризовывать данные, определяя состояние пользователя в произвольный момент времени при помощи обычной веб-камеры и специализированного софта, анализировать посредством него не только эмоции, но и физиологические и поведенческие аспекты, фиксировать малейшие изменения настроения и самочувствия человека, попавшего в объектив.

Самый яркий кейс

Пожалуй наивысшим достижением с точки зрения рынка стал основанный «Пикард» и её аспиранткой из MIT Раной Эль Калибу (Rana el Kaliouby) стартап Affectiva. Компания, возникшая в 2009 году, в четырех последовательных венчурных раундах привлекла за истекшие годы совокупный объем инвестиций более чем в $25 млн и не намерена останавливаться на достигнутом.

В активе у компании крупнейшая в мире база проанализированных лиц — более пяти миллионов экземпляров, а также бесценный опыт первопроходца в ряде индустрий, где до того технология распознавания эмоций практически не принималась в расчет, однако сам анализ по-прежнему ведется только в пределах семи базовых эмоций и одного канала (микроэкспрессии лица).

Кроме того, компания сделала доступным для сторонних разработчиков SDK, выложенный на платформе Unity, что позволяет им при необходимости интегрировать эмоциональный аналитический слой в начинку новых приложений и девайсов.

Affectiva уделяет много сил и большое внимание установлению партнерских контактов с бизнесом и академической наукой, запуску совместных проектов в различных отраслях (с Uber, Tesla, Qualtrics, сюда же относится релиз игры с обратной эмоциональной связью Nevermind и другие), внедрению самого концепта Emotion A.I. (эмоционального искусственного интеллекта) в бизнес-среду и умы потребителей.

Так, к примеру, в сотрудничестве c Jury Lab LLC решение от Affectiva попробовали использовать в ходе судебных слушаний с привлечением присяжных, отслеживание эмоций которых дает возможность сторонам обвинения и защиты оттачивать аргументацию и выстраивать адекватную модель взаимодействия с участниками заседаний, ориентируясь не только на букву закона и рациональные соображения, но и на эмоциональный оклик, не всегда, конечно же, поддающийся рациональному контролю.

Узким местом стратегии Affectiva считается стремление к движению не вглубь, а вширь, без пересмотра постепенно устаревающей идеи о небольшом наборе базовых эмоций, с ориентацией на единственный модуль – микроэкспрессии, — недостаточный для полноценной трактовки эмоционального состояния индивида.

Кто ещё есть на рынке?

Если обозначить нынешнюю конфигурацию и карту рынка эмоциональных технологий одной фразой, то это «простая множественность». Парадокс в том, что рынок этой весьма юной индустрии заполнен разнообразными решениями и ярко упакованными продуктами, однако многие действующие компании типологически схожи (разница в маркетинговой политике), технологически не сильно продвинулись за последние годы и легко распределяются по нескольким нишам.

Тут заметны «старые» игроки, ушедшие в отрыв еще в середине – конце 2000 годов, а также многочисленные небольшие стартапы с нишевой или национальной спецификой. Упомянем ряд показательных примеров.

Кейс 1

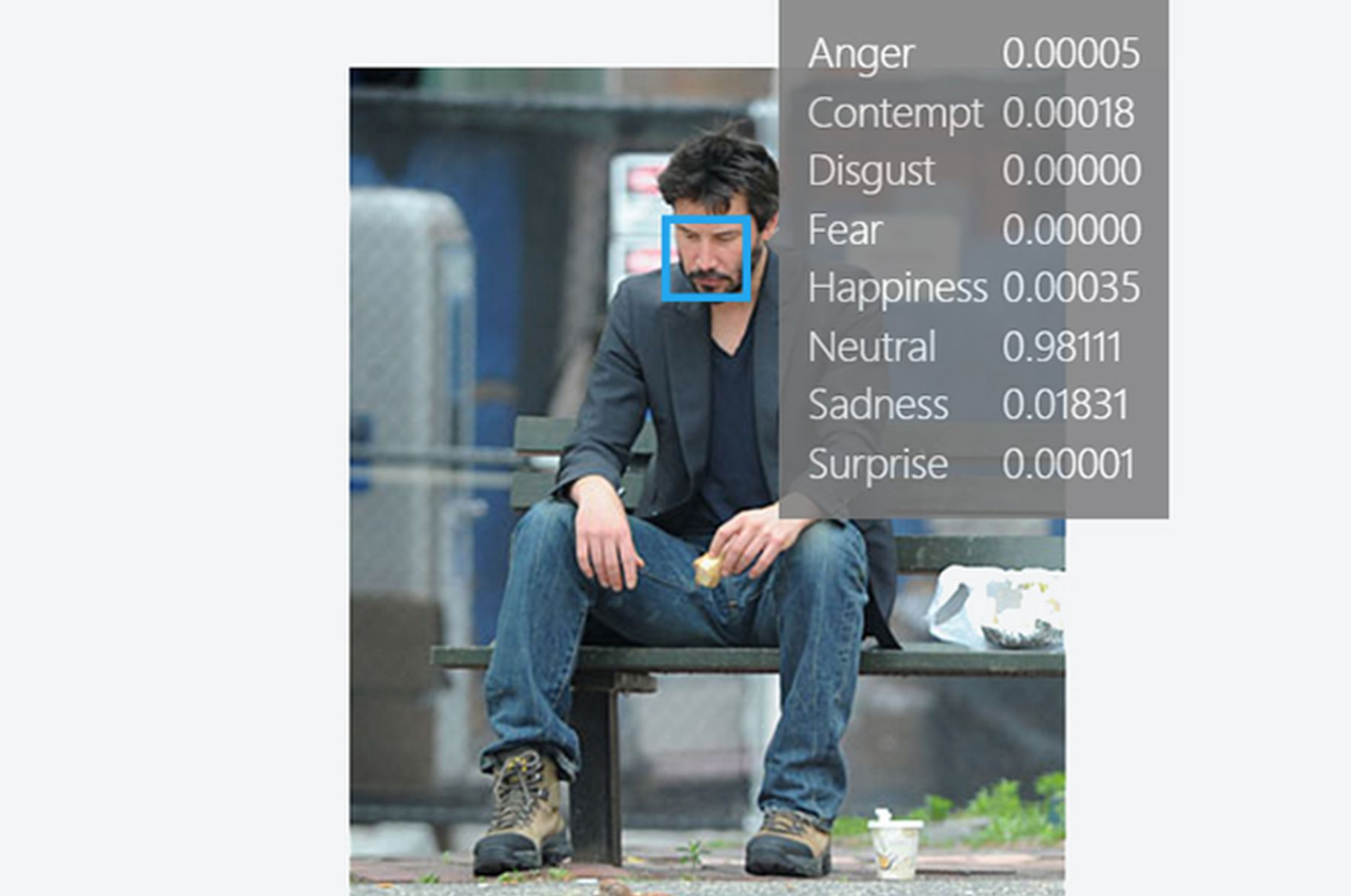

Проект «Оксфорд» (Project Oxford) от Microsoft представляет собой каталог готовых API (artificial intelligence APIs), сфокусированных на алгоритмах компьютерного зрения. Здесь мы имеем дело исключительно со статикой изображений: пользователю дается возможность загрузить произвольные фотографии, на которых детектируется лицо, и получить в итоге результат, разбитый на восемь корзинок (семь базовых эмоций плюс нейтральное состояние) в процентном соотношении до пяти цифр после запятой по каждой позиции.

Проект обрел в прошлом году вирусную популярность как по причине азарта пользователей, так и из-за периодически встречающихся несуразностей в трактовках выражений лиц. Как бы то ни было, но система предположила, к примеру, что на одной из фотографий показатель грусти актера Киану Ривза равен 0.01831.

Убедиться в том, корректна ли оценка машины и насколько она расходится с бытовым восприятием, может каждый. Попробуйте.

Кейс 2

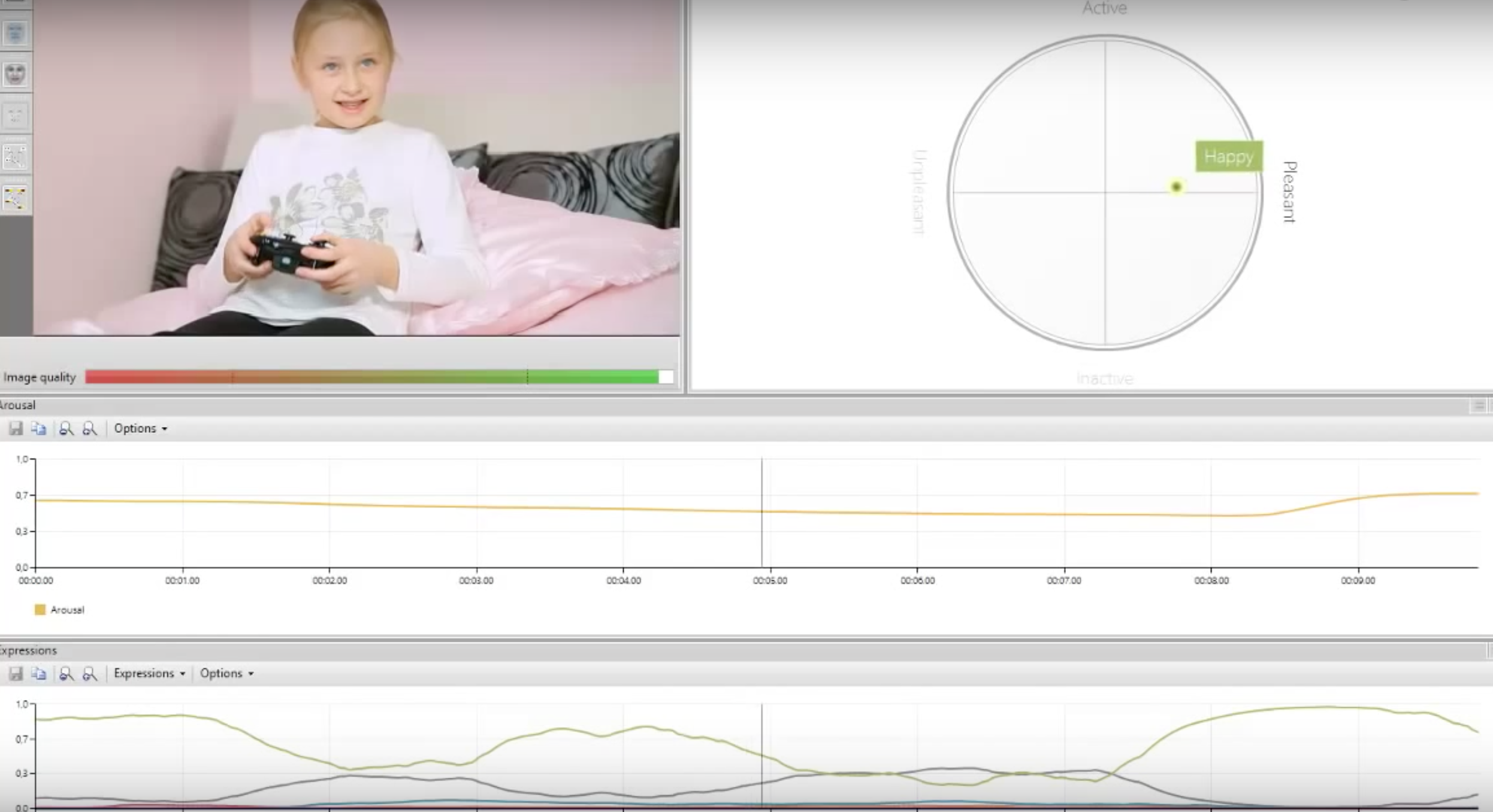

Более серьезным кейсом по мимической детекции эмоций можно счесть сервис FaceReader от нидерландской компании Noldus Information Technology. Программа способна интерпретировать микроэкспрессии лица, разнося их по все тем же восьми категориям: радость, грусть, гнев, удивление, страх, отвращение, презрение и нейтральная.

FaceReader умеет с высокой точностью «ловить» направление взгляда, фиксировать ориентацию головы, определять по лицам возраст, пол и иные персональные характеристики. Программа опирается на технологии компьютерного зрения.

В частности, речь идет о методе Active Template, заключающемся в наложении на изображение лица деформируемого шаблона, и методе Active Appearance Model, позволяющем создавать искусственную модель лица по контрольным точкам с учетом деталей поверхности.

По словам разработчиков, классификация происходит посредством нейронных сетей с тренировочным корпусом в 10 тыс. кадров.

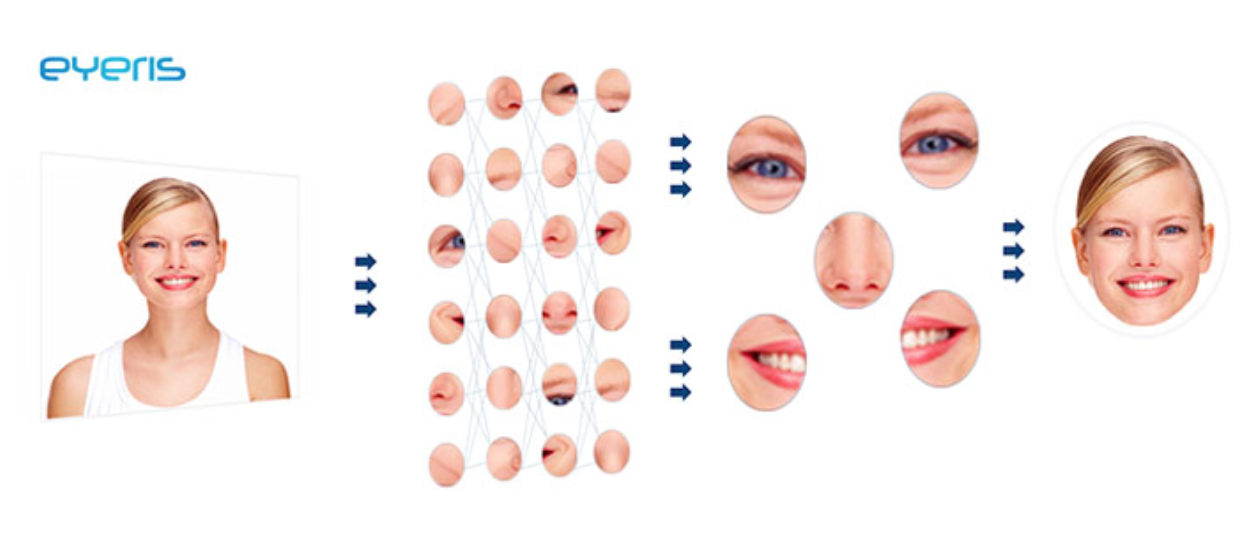

Кейс 3

В похожем русле функционирует сервис Emovu от калифорнийской компании Eyeris. Решение инкорпорирует алгоритмы компьютерного зрения и глубокого обучения для анализа большого набора признаков (микроэкспрессии, айтрекинг, моргания, наклоны головы и так далее), что применяется в том числе для считывания эмоционального отклика, вовлеченности и заинтересованности человека тем контентом, что демонстрируется ему в потоке видео.

Компания пристально следит за тенденциями в области интеллектуальных систем транспорта и сотрудничает с автомобильными концернами (такими, как Toyota и Honda) на предмет внедрения технологий по распознаванию эмоций в полностью автономные беспилотные транспортные средства, где акцент в софтверном оснащении и сервисах смещается к пассажирам, их ощущениям, потребностям, динамике состояний во времени.

К физиологии как источнику информации об эмоциях человека нередко прибегают в клинических испытаниях. Например, этот способ детекции эмоций был встроен в метод БОС (биологической обратной связи), когда пациенту на экран монитора компьютера «возвращаются» текущие значения его физиологических показателей, определяемых клиническим протоколом: кардиограмма, частота сердечных сокращений, электрическая активность кожи (ЭАК) и другие.

Кейс 4

Сюда же включаются и опыты, обращающиеся к подкожному кровотоку лица (изменению цвета пикселя): стоит упомянуть выросший в университете Торонто стартап NuraLogix с его трансдермальной оптической технологией, высокочувствительной, настроенной на вычленение скрытых эмоций, но пока еще крайне зависимой от источников света и условий среды.

Пилотные тесты в нескольких универмагах Торонто обнадеживают, а гранты канадских центров по поддержке инноваций (> $100 тыс.) позволяют компании готовить релизы обновленных версий программы.

Кейс 5

Такие приемы нашли применение и в других сферах. Например, определение эмоций по физиологическим данным является несущей функцией устройства MindWave Mobile от NeuroSky, которое надевается на голову и запускает встроенный датчик мозговой активности. Он устанавливает степень концентрации, расслабления либо беспокойства человека, оценивая ее по шкале от 1 до 100.

MindWave Mobile адаптирует способ регистрации ЭЭГ, принятый в научных исследованиях. Только в этом случае система оснащена всего одним электродом, в отличие от лабораторных установок, где их количество может быть гораздо больше десяти.

Борьба за здоровый образ жизни в урбанистических контекстах мегаполисов породила спрос на фитнес-браслеты, в которые органично вписалась и эмоциональная составляющая.

Кейс 6

Например, компания Sentio Solutions спроектировала стильный браслет-аксессуар Feel, отслеживающий, распознающий и собирающий данные об испытываемых человеком эмоциях в течение всего дня. Одновременно мобильное приложение предлагает рекомендации, которые должны сформировать у пользователя положительные, в том числе в эмоциональном плане, привычки.

Впаянные в продукт сенсоры мониторят параллельно сразу несколько физиологических параметров, таких как пульс, кожно-гальванические реакции, температуру кожи, а алгоритмы системы переводят биологические сигналы на «язык» эмоций.

Кейс 7

Одним из бесспорных лидеров эмоциональных голосовых технологий является израильская компания Beyond Verbal Communications. Обладая знаниями, собранными за 21 год академических исследований, о том, что от 35 до 40% минимум эмоциональной информации, передаваемой в человеческих коммуникациях, содержится в вокальных интонациях, программный продукт компании анализирует сырые десятисекундные записи (samples) и извлекает из них данные, свидетельствующие об эмоциях, настроении, речевых привычках, стрессе, а также самочувствии человека.

Компания по праву гордится базой приблизительно в 2,3 млн уникальных образцов голоса на сорока языках мира. Сегодняшняя долгосрочная стратегия проекта оказывается на пересечении цифровой медицины и встраиваемых виртуальных ассистентов: определение эмоций по голосу снимает проблему множества слепых пятен, присущих классическим VPA (вроде Amazon Echo), интенсифицируя процесс повсеместного внедрения умных помощников.

Зачем следить за движением глаз?

Само собой, нельзя пропускать и тему отслеживания эмоций по данным движений глаз, основные параметры которых — фиксации и саккады. Наиболее распространенный метод их регистрации называется видеоокулографией (или айтрекингом, более привычная калька с английского термина), принцип её действия заключается в записи движения глаза с высокой частотой.

Видеоокулография применяется как в науке, так и в игровой индустрии и онлайн-маркетинге (нейромаркетинге). Решающее значение при покупке в онлайн-магазине имеет месторасположение информации о продукте, способствующей конверсии. Требуется и досконально учитывать позиции баннеров и прочей рекламной продукции.

Например, Google работает над оформлением поверхностей отображения на странице выдачи с использованием айтрекинга, чтобы генерировать максимально эффективные предложения для рекламодателей. Адекватный аналитический подход видеоокулографии оказывается полезен и веб-дизайнерам, поскольку способствует тому, чтобы информация above the fold лучше воспринималась пользователями.

Мы совместно с командой разработчиков из Ocutri создали прототип софтового айтрекера Eye Catcher 0.1, позволяющего извлекать данные движений глаз и головы из видеофайлов, записанных на обычную камеру. Эта технология открывает новые горизонты в изучении движений глаз человека в естественных условиях и ощутимо расширяет исследовательские возможности.

В целом в индустрии айтрекинга наблюдается любопытный феномен резкого сокращения числа независимых игроков. Крупнейшие производители окулографических систем — вроде шведской компании Tobii и канадской Eyelink — для юзабилити-тестов и прочих нужд черпают дополнительные ресурсы из внешних источников и укрепляют свои полумонопольные позиции.

Параллельно с этим корпорации скупают компании и стартапы средних размеров:

- Google приобрел Eyefluence,

- Facebook – EyeTribe,

- Apple в июне 2017 года – немецкую компанию SMI с её брендированной технологией захвата и записи взгляда в real-time mode с частотой дискретизации до 120 Гц.

А что дальше?

Грядущих развилок у индустрии немало, исследовательских и технологических узлов, требующих разрешения, еще больше. И всё же длительная перспектива (хотя бы до середины – конца 2020-х гг.) очевидна.

R&D команды, центры компетенций, лаборатории в области «эмоциональных вычислений» и EDRS непременно найдут способ выйти за пределы узких рамок моно- или биканальной логики, а следовательно, приблизиться вплотную к реальным комплексным мультимодальным технологиям детекции и интерпретации сложносоставных эмоциональных состояний.

Лучшие умы человечества стремятся разобраться с тем, как устроены психологические феномены, каковы нейробиологические механизмы, чтобы воспроизвести их внутри вычислительных систем с неклассической архитектурой, вдохновленной постепенно накапливающимися знаниями о работе неокортекса.

При том что ускорение на этом пути, а такого мнения придерживается Курцвейл, неизбежно. Стоит набраться терпения. Так или иначе, но инжиниринг EI (emotional intelligence) приближает эпоху искусственного интеллекта: истинно очеловеченным интеллект машины станет только тогда, когда логика будет сбалансирована чувствами, эмоциями, ощущениями.

В конце концов, перефразируя Декарта, действительность XXI века, в которую мы уже погружены, нередко сводится к лаконичной формуле Sentio, ergo sum (я чувствую, значит, я существую). Едва ли тут что-то изменится кардинально.

Материалы по теме:

Топ-менеджер Hyperloop One: Россия может стать первой страной с Hyperloop

Как роботы отнимают работу у поэтов, художников и музыкантов

8 предсказаний Роберта Скоубла о будущем AR/VR-технологий

Канадские ученые представили дрон, способный приземляться на стены

Где стартапы могут победить технологических гигантов: 5 направлений

Нашли опечатку? Выделите текст и нажмите Ctrl + Enter

Популярное

Налог на прибыль организаций

Материалы по теме

-

Пройти курс «Старт работы на Яндекс Маркете»

- 1 Бум на дубайский шоколад вызвал глобальный дефицит фисташек Из-за ажиотажного спроса растут цены на этот вид орехов 21 апреля 14:34

- 2 Что такое Snapchat: полное руководство по приложению Гид для взрослых по самому популярному приложению в мире подростков 21 марта 13:16

- 3 Топ-10 самых востребованных языков программирования в 2025 году Сохранится ли лидерство Python? 12 марта 19:53

- 4 Как подготовить локальный бизнес к летнему сезону: советы и идеи К сезону лучше готовиться заранее 03 марта 16:20