Обычно SEO-специалистам платят за то, чтобы сайт занял верхние строчки на страницах поисковых систем. Но после того как файлы Google Docs попали в выдачу «Яндекса», и на это обратили внимание журналисты и «Роскомнадзор», компании начали делать все, чтобы страницы с конфиденциальной информацией ни в коем случае не оказались в поисковой выдаче. Никита Тарасов, руководитель группы оптимизаторов в «Ашманов и партнеры», рассказывает, почему случаются утечки, как их обнаружить и предотвратить.

Какие данные рискуют попасть в поиск и почему

Утечками непубличной информации в поисковые системы грешат мелкие и крупные интернет-магазины, банки, госучреждения, сервисы и так далее. У одних проектов проблема связана с тем, что в штате нет SEO-специалистов и нет понимания, что угроза вообще существует. У других специалисты есть, но внесение правок даже в банальный файл robots.txt растягивается на месяцы из-за большого количества согласований. Это беда многих крупных интернет-компаний.

В обоих случаях есть риск, что поисковые системы проиндексируют сведения, о которых не принято говорить вслух. Например, связки логинов и паролей, сканы паспортов, номера банковских карт, клиентские базы, отчетность.

В прошлом году стало известно, что Google проиндексировал тексты, которые пользователи переводили с помощью облачного сервиса Translate.com. Среди них оказались внутренние документы крупной международной компании Statoil. Речь шла про данные контрактов, планы по сокращению штата, пароли. Translate.com рассказали, что сохраняли тексты пользователей для волонтеров (асессоров), которые обучали алгоритм онлайн-переводчика. К сожалению, сотрудники сервиса не позаботились о том, чтобы закрыть информацию от индексации.

Угроза утечки данных через облачные сервисы существует, но гораздо чаще непубличная информация попадает в поисковики непосредственно с сайтов компаний. Например, сотрудники забывают закрыть страницы от индексации после переезда на новый сайт. Я бы хотел подробнее разобрать эту проблему ниже и заодно расскажу, как ее избежать.

Как обнаружить утечку

В этом разделе я опишу последовательность действий, которые помогут выявить страницы с конфиденциальными данными в поиске.

Проверьте служебные домены и поддомены сайта

Важно сразу понять, что источником утечки часто становится не только основной сайт или конкретные разделы, но и служебные домены или поддомены.

Давайте рассмотрим вопрос на примере из жизни. Интернет-магазин компании входит в топ-10 «Яндекса» в своем сегменте. Анализ показал, что у сайта существует порядка 15 поддоменов, включая тестовые и служебные. Примечательно, что на одном из них размещена web-версия 1C.

Примеры служебных поддоменов:

- http://buhgalter.site.ru

- http://developer.site.ru

- поддомены сайта не были закрыты от индексации в файле robots.txt;

- на поддоменах использовался http-протокол, что делало их незащищенными для злоумышленников;

- авторизация в web-версии 1C не была защищена паролем, поэтому любой пользователь мог авторизоваться в системе и увидеть финансовую отчетность.

Все поддомены индексировались, и любой пользователь поисковика имел доступ к конфиденциальной информации. Чтобы выяснить, какие поддомены вашего сайта индексируются поисковыми системами, рекомендую использовать сервисы RDS или «Пиксель Тулс».

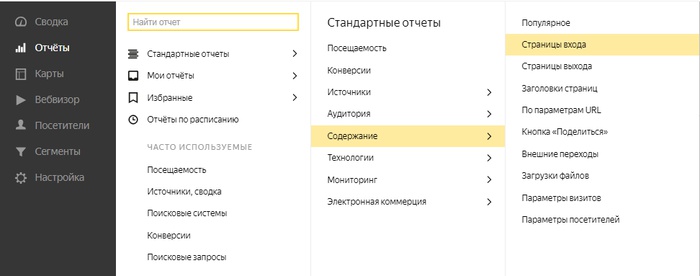

Еще не будет лишним проверить поддомены через системы web-аналитики. Как правило, один и тот же код счетчика «Яндекс.Метрики» или Google Analytics размещен как на основном домене, так и на тестовых/служебных поддоменах. Поэтому системы веб-аналитики могут помочь в выявлении подконтрольных доменов и поддоменов. Их наличие можно определить при помощи стандартного отчета «Страницы входа», как на примере ниже.

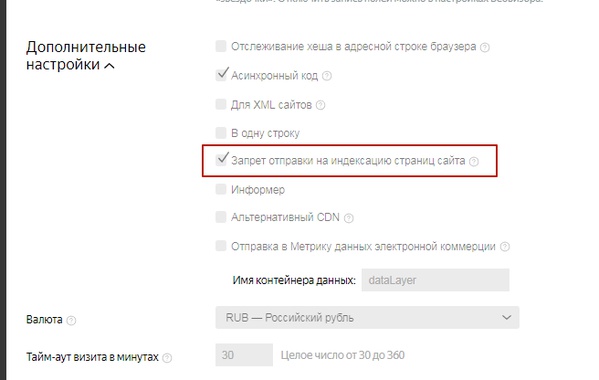

Кстати, по умолчанию «Яндекс.Метрика» отправляет на индексацию любые страницы сайта, по которым переходили пользователи. Но в дополнительных настройках счетчика «Яндекс.Метрики» есть чек-бокс «Запрет отправки на индексацию страниц сайта». Чтобы страницы с персональными данными не попали в индекс поисковых систем, сделайте чек-бокс активным.

Проанализируйте список страниц из индекса поисковых систем

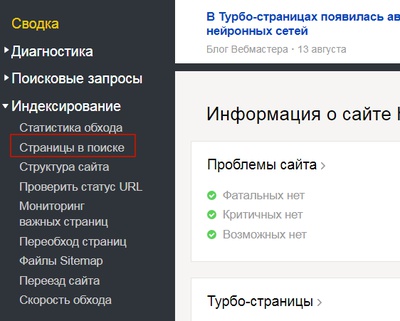

Обязательно проверьте страницы сайта, которые уже были проиндексированы и доступны, например, в поиске «Яндекса». Сделать это можно при помощи сервиса «Яндекс.Вебмастер». В разделе «Страницы в поиске» вы найдете весь список проиндексированных страниц.

Альтернативным вариантом получения данных о страницах, находящихся в поиске, является использование парсеров. Например, ComparseR или A-parser.

Полученный список можно обработать в любом табличном редакторе типа Excel и выявить страницы, которые не должны быть в поиске.

Другим способом обнаружения конфиденциальных страниц, является полное выкачивание сайта. Провести подобное тестирование можно при помощи программ-пауков или «краулеров»: Screaming frog seo spider или Netpeak spider. Они помогают проанализировать все ссылки на сайте и получить список страниц, которые хотя бы в теории доступны поисковому роботу.

Проанализировав полученный список, можно определить, какие типы страниц не стоит индексировать. Например, страницы авторизации, типа https://www.site.ru/auth/. Такие страницы даже если и не несут угрозы, то не представляют какую-либо ценность для поисковых систем. Поэтому исключить их из индекса стоит в любом случае.

Для этого нужно сделать следующее:

- закрыть страницы от индексации в robots.txt;

- запретить индексацию при помощи тегов, например <meta name="robots" content="noindex, follow"/>.

Отмечу, что эти рекомендации учитываются поисковиками в большинстве случаев, но не во всех. Поэтому лучше используйте ни какой-то один из описанных способов, а все одновременно.

Другой иллюстрацией проблемы может быть полное отсутствие robots.txt, в результате чего служебные ресурсы могут попасть в индекс целиком. По этой причине, например, поддомен одного из крупных банков, предназначенный для сотрудников, был доступен для любого пользователя.

Как убрать страницы из поиска

Самый простой способ – закрыть страницы от индексации в файле robots.txt.

Рекомендации по составлению файла robots.txt приведены в справках «Яндекса» и Google:

- https://yandex.ru/support/webmaster/controlling-robot/

- https://support.google.com/webmasters/answer/6062608?hl=ru

После корректировки файла, протестируйте его например, «Яндекс.Вебмастере» в разделе «Анализ Robots.txt». У Google есть аналогичный инструмент, но доступен он только после подтверждения прав на конкретный сайт.

Замечу, что robots.txt – это лишь набор правил для поисковых роботов, и иногда они могут не сработать. Тогда запрещенные для индексации страницы все равно попадут в поиск.

Поэтому лучше подстраховаться и запретить доступ к определенным разделам/директориям при помощи соответствующих кодов ответа сервера (например, 403), то есть сделать разделы доступными только при авторизации.

Сколько времени нужно, чтобы исправить ситуацию

После прочтения колонки может сложиться впечатление, что проблема индексации конфиденциальных данных решается легко и быстро. Но если утечка произошла, в среднем устранение занимает от двух до шести недель, потому что поисковым системам требуется время на переиндексацию изменений. Масштаб бедствия определяется тем, какое количество страниц с конфиденциальными данными попало в поисковый индекс.

Ускорить процесс можно при помощи следующих инструментов:

И, конечно, стоит обратиться в службу технической поддержки конкретной поисковой системы, чтобы максимально ускорить удаление страниц с конфиденциальными данными из индекса.

Как жить дальше

В начале колонки я упомянул, что индексация конфиденциальной информации случается у всех, даже у самых передовых IT-компаний. Если сайт собирает персональные или платежные данные посетителей, служебные или коммерческие документы, то аудит утечки стоит проводить регулярно. Любые изменения на сайте, переезд на новую CMS, смена подрядчиков по разработке или SEO могут повлиять на то, какие страницы попадут в индекс. Поэтому сделать проверку один раз и забыть о проблеме, к сожалению, не получится.

Если вы работаете с SEO-агентством или специалистом, поинтересуйтесь, проводились ли проверки по поиску и устранению из индекса поисковых систем служебных страниц и страниц, содержащих персональные данные. Если да – узнайте, какие именно меры были предприняты. Если нет – задумайтесь о компетенции подрядчика и дальнейшего сотрудничества с ним.

Материалы по теме:

Кто ты в анализе данных? Десять ролей в команде дата-аналитиков

Технологии кибербезопасности: какие решения перспективны и можно ли полностью защититься уже сейчас

Руководство по конфиденциальности в интернете – как обезопасить свои данные

Как данные из социальных сетей влияют на стоимость медицинских услуг в США

Исследование: эксперты назвали причину утечек информации в компаниях

Фото на обложке: Unsplash

Нашли опечатку? Выделите текст и нажмите Ctrl + Enter

Материалы по теме

- 1 SEO для локального бизнеса: как выйти на первые позиции в поиске по регионам

- 2 Бесполезная аналитика: 5 ошибок российских компаний в работе с данными

- 3 Внутренний туризм и маркетинг: как обеспечить постоянный поток клиентов в 2024 году

- 4 SEO-продвижение малого бизнеса

- 5 Тренды SEO: что будет популярно в 2024 году